¿Cómo optimizar tu presupuesto de rastreo? En esta guía, descubre los mejores consejos para hacer que tu sitio web sea lo más rastreable posible para SEO.

- 1. Prohibir el rastreo de URLs de acción en el archivo Robots.txt.

- 2. Cuidado con las cadenas de redirección.

- 3. Utiliza Renderización del Lado del Servidor (HTML) Siempre que Sea Posible.

- 4. Mejora la Velocidad de Carga de la Página

- 5. Cuida tus Enlaces Internos

- 6. Actualiza tu Sitemap

- 7. Implementa el Código de Estado 304

- 8. Las Etiquetas Hreflang Son Vitales

- 9. Monitoreo y Mantenimiento

- Conclusión

El presupuesto de rastreo es un concepto vital de SEO para sitios web grandes con millones de páginas o sitios web de tamaño medio con unos pocos miles de páginas que cambian diariamente.

Un ejemplo de un sitio web con millones de páginas sería eBay.com, y sitios web con decenas de miles de páginas que se actualizan con frecuencia serían sitios de reseñas de usuarios y calificaciones, similares a Gamespot.com.

Hay tantas tareas y problemas que un experto en SEO debe considerar, que el rastreo a menudo se deja en segundo plano.

Sin embargo, el presupuesto de rastreo puede y debe ser optimizado.

En este artículo, aprenderás:

- Cómo mejorar tu presupuesto de rastreo a lo largo del camino.

- Revisar los cambios en el concepto de presupuesto de rastreo en los últimos años.

¿Qué es el presupuesto de rastreo?

El presupuesto de rastreo se refiere a la cantidad de páginas que los rastreadores de motores de búsqueda (es decir, spiders y bots) visitan dentro de un período de tiempo determinado.

Existen ciertas consideraciones que influyen en el presupuesto de rastreo, como un equilibrio tentativo entre los intentos de Googlebot de no sobrecargar tu servidor y el deseo general de Google de rastrear tu dominio.

La optimización del presupuesto de rastreo es una serie de pasos que puedes tomar para aumentar la eficiencia y la frecuencia con la que los bots de los motores de búsqueda visitan tus páginas.

¿Por qué es importante la optimización del presupuesto de rastreo?

El rastreo es el primer paso para aparecer en los resultados de búsqueda. Sin ser rastreadas, las nuevas páginas y las actualizaciones de páginas no se añadirán a los índices de los motores de búsqueda.

Cuanto más frecuentemente los rastreadores visiten tus páginas, más rápido aparecerán las actualizaciones y nuevas páginas en el índice. Como resultado, tus esfuerzos de optimización tardarán menos en surtir efecto y empezar a influir en tus rankings.

El índice de Google contiene cientos de miles de millones de páginas y sigue creciendo cada día. A los motores de búsqueda les cuesta rastrear cada URL, y con el creciente número de sitios web, quieren reducir los costos computacionales y de almacenamiento al disminuir la tasa de rastreo y la indexación de URLs.

También hay una creciente urgencia por reducir las emisiones de carbono para combatir el cambio climático, y Google tiene una estrategia a largo plazo para mejorar la sostenibilidad y reducir las emisiones de carbono.

Estas prioridades podrían hacer que en el futuro sea más difícil que los sitios web sean rastreados de manera efectiva. Aunque el presupuesto de rastreo no es algo de lo que debas preocuparte si tienes sitios web pequeños con unas pocas cientos de páginas, la gestión de recursos se convierte en un tema importante para sitios web masivos. Optimizar el presupuesto de rastreo significa hacer que Google rastree tu sitio web utilizando la menor cantidad de recursos posible.

Así que, hablemos de cómo puedes optimizar tu presupuesto de rastreo en el mundo actual.

1. Prohibir el rastreo de URLs de acción en el archivo Robots.txt.

Puede que te sorprenda, pero Google ha confirmado que prohibir URLs no afectará tu presupuesto de rastreo. Esto significa que Google seguirá rastreando tu sitio web a la misma velocidad. Entonces, ¿por qué lo discutimos aquí?

Bueno, si prohibes URLs que no son importantes, básicamente le estás diciendo a Google que rastree las partes útiles de tu sitio web a una velocidad más alta.

Por ejemplo, si tu sitio web tiene una función de búsqueda interna con parámetros de consulta como /?q=google, Google rastreará estas URLs si están enlazadas desde algún lugar.

De manera similar, en un sitio de comercio electrónico, podrías tener filtros de facetas que generan URLs como /?color=red&size=s.

Estos parámetros de cadena de consulta pueden crear un número infinito de combinaciones únicas de URL que Google puede intentar rastrear.

Esas URLs, básicamente, no tienen contenido único y solo filtran los datos que tienes, lo cual es excelente para la experiencia del usuario, pero no para Googlebot.

Permitir que Google rastree estas URLs desperdicia el presupuesto de rastreo y afecta la rastreabilidad general de tu sitio web. Al bloquearlas mediante reglas en robots.txt, Google enfocará sus esfuerzos de rastreo en páginas más útiles de tu sitio.

Aquí te mostramos cómo bloquear la búsqueda interna, facetas o cualquier URL que contenga cadenas de consulta a través de robots.txt:

- Prohibir: ?s=

- Prohibir: ?color=

- Prohibir: ?size=

Cada regla prohíbe cualquier URL que contenga el parámetro de consulta respectivo, sin importar otros parámetros que puedan estar presentes.

- *(asterisco) coincide con cualquier secuencia de caracteres (incluyendo ninguno).

- ? (signo de interrogación): Indica el comienzo de una cadena de consulta.

- = (signo igual): Coincide con el signo = y cualquier carácter que le siga.

Este enfoque ayuda a evitar la redundancia y asegura que las URLs con estos parámetros de consulta específicos sean bloqueadas de ser rastreadas por los motores de búsqueda.

Sin embargo, ten en cuenta que este método garantiza que cualquier URL que contenga los caracteres indicados será prohibida sin importar dónde aparezcan los caracteres. Esto puede llevar a prohibiciones no intencionadas. Por ejemplo, los parámetros de consulta que contienen un solo carácter bloquearán cualquier URL que contenga ese carácter, independientemente de dónde aparezca. Si prohibes ‘s’, las URLs que contienen ‘/?pages=2’ serán bloqueadas porque *?*s= también coincide con ‘?pages=’. Si deseas prohibir URLs con un carácter específico, puedes usar una combinación de reglas:

- Prohibir: ?s=

- Prohibir: &s=

El cambio crítico es que no hay un asterisco ‘*’ entre los caracteres ‘?’ y ‘s’. Este método te permite prohibir parámetros ‘s’ específicos y exactos en las URLs, pero necesitarás agregar cada variación de manera individual.

Aplica estas reglas a tus casos de uso específicos para cualquier URL que no proporcione contenido único. Por ejemplo, en caso de que tengas botones de lista de deseos con URLs “?add_to_wishlist=1”, necesitas prohibirlos mediante la regla:

- Prohibir: /*?add_to_wishlist=

Esto es algo obvio y un primer paso natural y más importante recomendado por Google.

Un ejemplo a continuación muestra cómo bloquear esos parámetros ayudó a reducir el rastreo de páginas con cadenas de consulta. Google estaba tratando de rastrear decenas de miles de URLs con diferentes valores de parámetros que no tenían sentido, lo que conducía a páginas inexistentes.

Sin embargo, a veces las URLs prohibidas pueden ser rastreadas e indexadas por los motores de búsqueda. Esto puede parecer extraño, pero generalmente no es motivo de alarma. Usualmente significa que otros sitios web enlazan a esas URLs.

Google confirmó que la actividad de rastreo disminuirá con el tiempo en estos casos.

Otro beneficio importante de bloquear estas URLs a través de robots.txt es el ahorro de recursos del servidor. Cuando una URL contiene parámetros que indican la presencia de contenido dinámico, las solicitudes irán al servidor en lugar de a la caché. Esto aumenta la carga en tu servidor con cada página rastreada.

Por favor, recuerda no usar la «metaetiqueta noindex» para bloquear, ya que Googlebot tiene que realizar una solicitud para ver la meta etiqueta o el código de respuesta HTTP, lo que desperdicia el presupuesto de rastreo.

1.2. Prohibir URLs de Recursos No Importantes en Robots.txt

Además de prohibir URLs de acción, es posible que desees prohibir archivos JavaScript que no sean parte del diseño o la renderización del sitio web.

Por ejemplo, si tienes archivos JavaScript responsables de abrir imágenes en una ventana emergente cuando los usuarios hacen clic, puedes prohibirlos en robots.txt para que Google no desperdicie presupuesto rastreándolos.

Aquí tienes un ejemplo de la regla de prohibición para un archivo JavaScript:

Prohibir: /assets/js/popup.js

Sin embargo, nunca debes prohibir recursos que sean parte de la renderización. Por ejemplo, si tu contenido se carga dinámicamente a través de JavaScript, Google necesita rastrear los archivos JS para indexar el contenido que cargan.

Otro ejemplo son los puntos finales de la API REST para envíos de formularios. Supongamos que tienes un formulario con la URL de acción “/rest-api/form-submissions/”.

Potencialmente, Google puede rastrearlos. Esas URLs no están relacionadas con la renderización y sería una buena práctica bloquearlas.

Prohibir: /rest-api/form-submissions/

Sin embargo, los CMS sin cabeza (headless CMS) a menudo utilizan APIs REST para cargar contenido dinámicamente, así que asegúrate de no bloquear esos puntos finales.

En resumen, identifica lo que no esté relacionado con la renderización y bloquéalo.

2. Cuidado con las cadenas de redirección.

Las cadenas de redirección ocurren cuando múltiples URLs redirigen a otras URLs que también redirigen. Si esto se prolonga demasiado, los rastreadores pueden abandonar la cadena antes de llegar al destino final.

La URL 1 redirige a la URL 2, que a su vez redirige a la URL 3, y así sucesivamente. Las cadenas también pueden tomar la forma de bucles infinitos cuando las URLs se redirigen entre sí.

Evitar estas cadenas es un enfoque de sentido común para la salud del sitio web.

Idealmente, deberías poder evitar tener incluso una sola cadena de redirección en todo tu dominio.

Pero puede ser una tarea imposible para un sitio web grande; las redirecciones 301 y 302 están destinadas a aparecer, y no puedes corregir redirecciones de backlinks entrantes simplemente porque no tienes control sobre sitios web externos.

Una o dos redirecciones aquí y allá puede que no causen mucho daño, pero las cadenas largas y los bucles pueden volverse problemáticos.

Para solucionar problemas de cadenas de redirección, puedes usar una de las herramientas de SEO como Screaming Frog, Lumar o Oncrawl para encontrar cadenas.

Cuando descubras una cadena, la mejor manera de solucionarlo es eliminar todas las URLs entre la primera página y la página final. Si tienes una cadena que pasa por siete páginas, redirige la primera URL directamente a la séptima.

Otra excelente manera de reducir las cadenas de redirección es reemplazar las URLs internas que redirigen con destinos finales en tu CMS.

Dependiendo de tu CMS, puede haber diferentes soluciones disponibles; por ejemplo, puedes usar este plugin para WordPress. Si tienes un CMS diferente, es posible que necesites usar una solución personalizada o pedirle a tu equipo de desarrollo que lo haga.

3. Utiliza Renderización del Lado del Servidor (HTML) Siempre que Sea Posible.

Ahora, si estamos hablando de Google, su rastreador utiliza la versión más reciente de Chrome y es capaz de ver el contenido cargado por JavaScript sin problemas.

Pero pensemos críticamente. ¿Qué significa eso? Googlebot rastrea una página y recursos como JavaScript, y luego gasta más recursos computacionales para renderizarlos.

Recuerda que los costos computacionales son importantes para Google, y quiere reducirlos tanto como sea posible.

Entonces, ¿por qué renderizar contenido a través de JavaScript (del lado del cliente) y agregar un costo computacional adicional para que Google rastree tus páginas?

Por eso, siempre que sea posible, deberías apegarte al HTML.

De esa manera, no estás perjudicando tus oportunidades con ningún rastreador.

4. Mejora la Velocidad de Carga de la Página

Como discutimos anteriormente, Googlebot rastrea y renderiza páginas con JavaScript, lo que significa que, si gasta menos recursos para renderizar páginas web, será más fácil para él rastrearlas, lo cual depende de qué tan bien optimizada esté la velocidad de tu sitio web.

Google dice:

El rastreo de Google está limitado por el ancho de banda, el tiempo y la disponibilidad de las instancias de Googlebot. Si tu servidor responde a las solicitudes más rápidamente, es posible que podamos rastrear más páginas de tu sitio.

Por lo tanto, utilizar la renderización del lado del servidor ya es un gran paso hacia la mejora de la velocidad de carga de la página, pero necesitas asegurarte de que tus métricas de Core Web Vitals estén optimizadas, especialmente el tiempo de respuesta del servidor.

5. Cuida tus Enlaces Internos

Google rastrea URLs que están en la página, y siempre ten en cuenta que diferentes URLs son contadas por los rastreadores como páginas separadas.

Si tienes un sitio web con la versión ‘www’, asegúrate de que tus URLs internas, especialmente en la navegación, apunten a la versión canónica, es decir, a la versión ‘www’ y viceversa.

Otro error común es no incluir una barra inclinada al final. Si tus URLs tienen una barra inclinada al final, asegúrate de que tus URLs internas también la tengan.

De lo contrario, las redirecciones innecesarias, por ejemplo, de “https://www.example.com/sample-page” a “https://www.example.com/sample-page/”, resultarán en dos rastreos por URL.

Otro aspecto importante es evitar páginas de enlaces internos rotos, que pueden consumir tu presupuesto de rastreo y causar páginas soft 404.

¡Y si eso no fuera suficiente, también perjudican la experiencia del usuario!

En este caso, de nuevo, estoy a favor de usar una herramienta para auditoría del sitio web.

WebSite Auditor, Screaming Frog, Lumar o Oncrawl, y SE Ranking son ejemplos de excelentes herramientas para una auditoría del sitio web.

6. Actualiza tu Sitemap

Una vez más, es realmente beneficioso cuidar de tu sitemap XML.

Los bots tendrán una comprensión mucho mejor y más fácil de hacia dónde conducen los enlaces internos.

Utiliza solo las URLs que son canónicas para tu sitemap.

Además, asegúrate de que corresponda a la versión más reciente de robots.txt que se haya subido y que se cargue rápidamente.

7. Implementa el Código de Estado 304

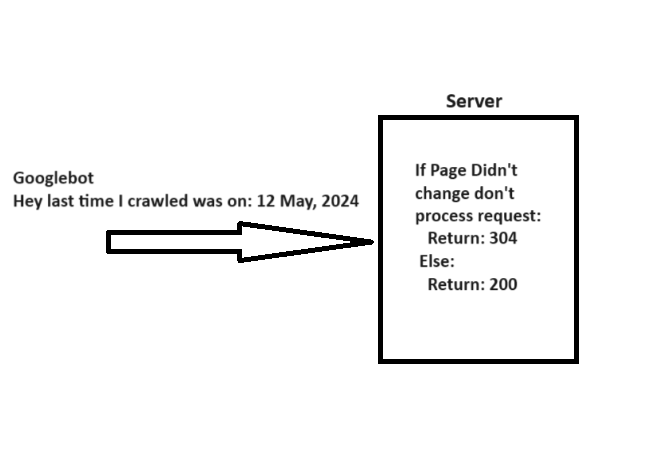

Al rastrear una URL, Googlebot envía una fecha a través del encabezado “If-Modified-Since”, que es información adicional sobre la última vez que rastreó la URL dada.

Si tu página web no ha cambiado desde entonces (especificado en “If-Modified-Since”), puedes devolver el código de estado “304 Not Modified” sin cuerpo de respuesta. Esto le indica a los motores de búsqueda que el contenido de la página web no ha cambiado, y Googlebot puede utilizar la versión de la última visita que tiene en el archivo.

Imagina cuántos recursos del servidor puedes ahorrar mientras ayudas a Googlebot a ahorrar recursos cuando tienes millones de páginas web. Bastante significativo, ¿verdad?

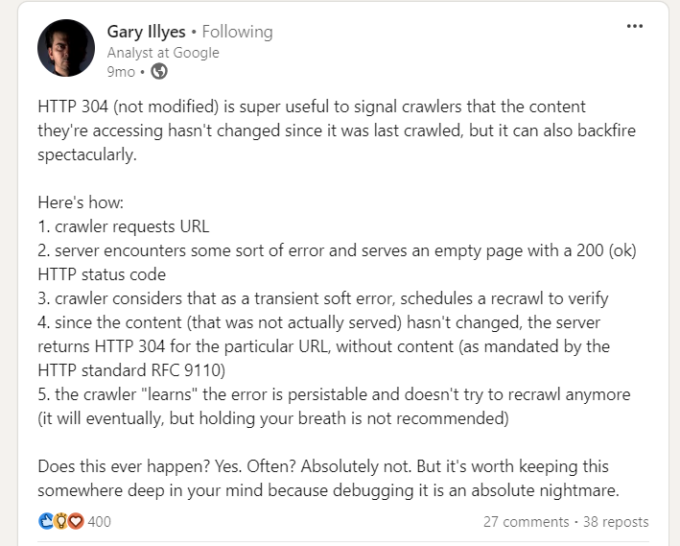

Sin embargo, hay una advertencia al implementar el código de estado 304, señalada por Gary Illyes.

Así que ten cuidado. Los errores del servidor que sirven páginas vacías con un estado 200 pueden hacer que los rastreadores dejen de volver a rastrear, lo que lleva a problemas de indexación duraderos.

8. Las Etiquetas Hreflang Son Vitales

Para analizar tus páginas localizadas, los rastreadores emplean etiquetas hreflang. Debes informar a Google sobre las versiones localizadas de tus páginas de la manera más clara posible.

Primero, utiliza el <link rel="alternate" hreflang="lang_code" href="url_of_page" /> en el encabezado de tu página. Donde “lang_code” es un código para un idioma soportado.

Debes usar el elemento <loc> para cualquier URL dada. De esa manera, puedes señalar las versiones localizadas de una página.

9. Monitoreo y Mantenimiento

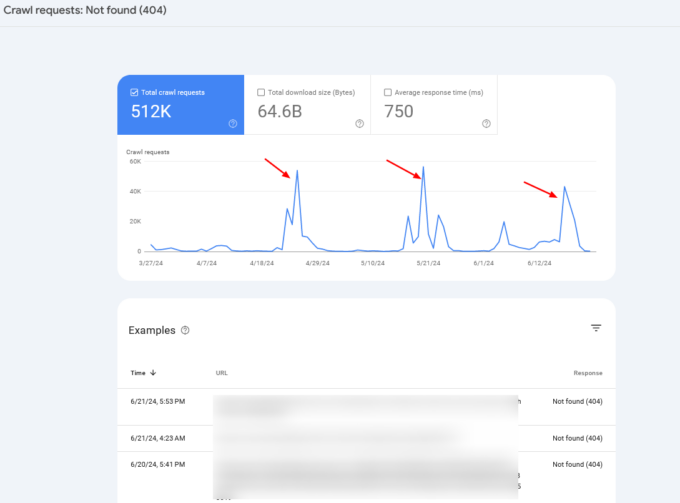

Revisa los registros de tu servidor y el informe de estadísticas de rastreo de Google Search Console para monitorear anomalías de rastreo e identificar problemas potenciales.

Si notas picos periódicos de rastreo de páginas 404, en el 99% de los casos, esto es causado por espacios de rastreo infinitos, que hemos discutido anteriormente, o indica otros problemas que tu sitio web puede estar experimentando.

A menudo, querrás combinar la información del registro del servidor con los datos de Search Console para identificar la causa raíz.

Conclusión

Así que, si te preguntabas si la optimización del presupuesto de rastreo sigue siendo importante para tu sitio web, la respuesta es claramente sí.

El presupuesto de rastreo es, ha sido y probablemente seguirá siendo una cosa importante a tener en cuenta para cada profesional de SEO.

Espero que estos consejos te ayuden a optimizar tu presupuesto de rastreo y mejorar tu rendimiento en SEO; pero recuerda, que tus páginas sean rastreadas no significa que serán indexadas.